Was ist ETL?

ETL bezieht sich auf Extrahieren, Transformieren und Laden. Es handelt sich um einen dreistufigen Prozess, der angewendet wird, um die Daten aus verschiedenen Quellen (die in verschiedenen Formen vorliegen können) zu extrahieren, zu bereinigen und zur Analyse in eine Zieldatenbank zu laden. ETL ist ein beliebter Prozess in der Data-Warehousing-Welt, bei dem Daten aus verschiedenen Datenquellen integriert und in eine Zieldatenbank geladen werden, um Analysen und Berichte für Unternehmen durchzuführen. In einfachen Kernbegriffen wird ETL verwendet, um die Daten aus einer Datenquelle wie einer Datenbank oder einer Datei zu extrahieren und dann zu bereinigen, gemäß den Geschäftsanforderungen zu transformieren und dann in die Zieldatenbank zu laden.

Der ETL-Prozess existiert in Form verschiedener Tools. Es gibt eine ganze Reihe beliebter ETL-Tools, die von Unternehmen häufig verwendet werden, um unterschiedliche Datenmigrationsanforderungen zu erfüllen. Obwohl diese Tools vorhanden sind, gibt es keine Garantie dafür, dass die Datenmigrationsanforderungen sofort erfüllt werden, weshalb sich DBAs und Entwickler oft dafür entscheiden, benutzerdefinierte ETLs zu erstellen, um komplexe Datenmigrationsherausforderungen in Echtzeit zu meistern.

Warum ETL?

Wann immer eine Datenmigration erforderlich ist, suchen DBAs oder Entwickler als Erstes nach einem ETL-Tool. Daten können in unterschiedlichen Formen vorliegen; B. in RDBMS-Datenbanken, Flatfiles, CSVs usw., und die Anforderung wäre, all diese Daten zu migrieren, in eine einzige Datenbank zu integrieren, oder wenn die Zieldatenbank eine andere ist, würde der Datentransformationsprozess kritisch werden. Diese Herausforderungen können durch ETL-Tools angegangen werden, die Kosten und Geschäftszeit sparen können. In der heutigen Welt kann das Fehlen von ETL-spezifischen Tools Unternehmen erhebliche Entwicklungsanstrengungen und Geld kosten, um einen effizienten automatisierten Prozess für die Datenmigration aufzubauen. Dank der Open-Source-Welt gibt es einige beliebte Open-Source-ETL-Tools, die komplexe Herausforderungen bei der Datenmigration in Echtzeit bewältigen können.

Während es verschiedene Gründe gibt, die Daten zu migrieren, möchte ich mich auf zwei typische Anforderungen für die Datenmigration konzentrieren...

- Migrieren Sie die Daten aus verschiedenen Quellen (Datenbank, Flatfiles und CSVs) in eine einzige Datenbank in einer Data-Warehousing-Umgebung, vermutlich eine Open-Source-Datenbank, was die Gesamtbetriebskosten für den Aufbau erheblich reduzieren würde DWH-Umgebungen. Dies wäre eine praktikable Option, da die Echtzeitanwendungen die bestehenden kommerziellen Datenbanken verwenden und das DWH die Daten in einer Open-Source-Datenbank hosten wird

- Migrieren Sie die Echtzeitdatenbanken und -anwendungen von kommerziellen Datenbanken zu Open-Source-Datenbanken wie PostgreSQL, um die Kosten für den Datenbetrieb für Unternehmen erheblich zu senken.

Mein Fokus in diesem Blog liegt auf der Identifizierung von ETL-Tools, die bei der Durchführung von Datenmigrationen in die PostgreSQL-Datenbank helfen können.

Warum zu PostgreSQL migrieren?

PostgreSQL ist eine funktionsreiche Open-Source-Datenbank der Enterprise-Klasse, die die erste Option ist, die Unternehmen für ihre verschiedenen Anforderungen an den Echtzeit-Datenbetrieb wählen, und die in verschiedenen unternehmenskritischen Umgebungen implementiert ist. Nachdem sie das Potenzial dieser äußerst zuverlässigen und effizienten RDBMS-Datenbank erkannt haben, entscheiden sich immer mehr Unternehmen dafür, ihre Datenbanken und Anwendungen darauf zu migrieren. Die Migration der bestehenden Datenbanken zu PostgreSQL bringt erhebliche Einsparungen bei den IT-Kosten, weshalb „Migrationen zu PostgreSQL“ heutzutage eine ziemlich häufige Anforderung sind, und es kommt die Anforderung nach Datenmigration, wo die Suche nach einem ETL-Tool beginnt.

Wie oben erwähnt, gibt es eine ganze Reihe von kommerziellen und Open-Source-ETL-Tools, und so ziemlich alle Tools unterstützen PostgreSQL.

Laden Sie noch heute das Whitepaper PostgreSQL-Verwaltung und -Automatisierung mit ClusterControl herunterErfahren Sie, was Sie wissen müssen, um PostgreSQL bereitzustellen, zu überwachen, zu verwalten und zu skalierenLaden Sie das Whitepaper herunterWas sind die besten ETL-Tools?

Ora2pg

Ora2pg ist DIE OPTION, wenn Sie beabsichtigen, die Daten von der Oracle-Datenbank nach PostgreSQL zu migrieren. Es ist ein Perl-basiertes Open-Source-Tool, das speziell für die Migration von Schemadaten und Daten von Oracle-Datenbanken nach PostgreSQL entwickelt wurde und beide Datenbanken sehr gut versteht und Daten beliebiger Größe migrieren kann. Das Migrieren größerer Objekte kann zeit- und hardwareaufwändig sein.

Vorteile: Ora2pg ist ein sehr beliebtes Tool, das speziell für die Migration von Oracle-Datenbanken nach PostgreSQL verwendet wird. Unterstützt Windows- und Linux-Betriebssysteme und verwendet eine Textschnittstelle. Dieses Tool versteht beide Datenbanken sehr gut und ist aus funktionaler Sicht ziemlich zuverlässig. Als wir Daten in eine Produktionsumgebung migrierten, führte die Datenanalyse (oder Data Sanity) zu „0“ Datenfehlern, was ziemlich bemerkenswert ist. Ziemlich effizient bei der Migration von Datentypen wie Date/Timestamp und Large Objects. Einfach zu planende Jobs per Shell-Skript im Hintergrund. Die Antwort des Entwicklers auf Probleme auf Github ist gut.

Nachteile: Das Installationsverfahren von Ora2pg, das die Installation von Perl-Modulen, Oracle- und Postgres-Clients umfasst, kann je nach Betriebssystemversion zu einer komplexen Angelegenheit werden und noch komplexer werden, wenn dasselbe unter Windows-Betriebssystemen durchgeführt wird. Bei der parallelen Migration großer Tabellen mit „großen Objekten“ (d. h. ein ora2pg-Job mit mehreren Threads) kann es zu erheblichen Leistungsproblemen kommen, was zu einer erheblichen Änderung der Datenmigrationsstrategie führen kann.

Talend

Talend ist ein sehr beliebtes ETL-Tool, mit dem Daten aus beliebigen Quellen (Datenbank oder Datei) in beliebige Datenbanken migriert werden. Dieses Tool unterstützt die PostgreSQL-Datenbank und viele Unternehmen verwenden dieses Tool, um Daten nach PostgreSQL zu migrieren. Es gibt sowohl kommerzielle als auch Open-Source-Versionen dieses Tools, und die Open-Source-Version sollte für Datenmigrationen hilfreich sein.

Vorteile: Talend ist ein Java-basiertes ETL-Tool, das für Datenintegrationen verwendet wird und PostgreSQL unterstützt. Ein einfach zu installierendes Tool wird mit einer GUI mit Open-Source- und kommerziellen Versionen geliefert. Kann auf jeder Plattform ausgeführt werden, die Java unterstützt. Entwickler können benutzerdefinierten Java-Code schreiben, der in Talend integriert werden kann. Es ist keine große Sache, wenn Sie einen Entwickler oder einen DBA anweisen müssen, dieses Tool zu verwenden, um die Daten nach PostgreSQL zu migrieren. Kann Daten aus mehreren Quellen wie einer Datenbank oder einer Datei migrieren oder integrieren.

Nachteile: Das Planen von Jobs kann eine Herausforderung sein. Kann hauptsächlich verwendet werden, um Tabellen angemessener Größe mit nicht vielen Optimierungsoptionen zur Leistungsverbesserung zu migrieren. Möglicherweise keine gute Option, um riesige Größentabellen mit Millionen von Zeilen zu migrieren. Könnte grundlegende betriebliche Herausforderungen mit sich bringen. Benötigt Java-Expertise, um dieses Tool zu handhaben, insbesondere bei der Integration des benutzerdefinierten Codes. Es ist nicht einfach, innerhalb kurzer Zeit Komfort mit diesem Tool zu erreichen. Es ist nicht möglich, die Datenmigrationsjobs zu skripten und zu planen.

SQLINES

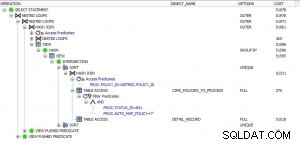

Sqlines ist ein weiteres Open-Source-ETL-Tool, das die Daten zu und von jeder Datenbank migrieren kann. Dies ist eine weitere gute Option, um Daten aus so ziemlich jeder kommerziellen oder Open-Source-Datenbank in PostgreSQL-Datenbanken zu migrieren. Ich persönlich bin von diesem Tool beeindruckt. Es wurde mit C/C++ entwickelt und ist sehr einfach zu verwenden, ohne Komplikationen beim Installationsprozess (einfach den Installer herunterladen und entpacken, fertig!). Da es sich um ein C/C++-basiertes Tool handelt, können große Leistungsgewinne bei der Migration großer Datenbanken erzielt werden. Ich würde sagen, dieses Tool entwickelt sich weiter und die Abonnementkosten für den Support sind sehr vernünftig.

Vorteile: Wie oben erwähnt, bin ich von der Tatsache beeindruckt, dass dieses Tool auf der Grundlage von C/C++ erstellt wurde, was ein großer Vorteil ist. Ganz einfach und einfach zu installieren und einzurichten. Verwendet eine Textschnittstelle, die es wirklich einfach macht, Jobs über Bash-Skripte zu planen. Kann große Datenmengen verarbeiten. Der Support von den Entwicklern ist gut zu einem sehr vernünftigen Preis. Entwickler sind offen dafür, Ihre Ideen aufzunehmen und umzusetzen, was es zu einer noch besseren Option macht.

Nachteile: Nicht viele Leute kennen dieses Tool und es entwickelt sich weiter. Es gibt nicht viele Konfigurationsoptionen, um herumzuspielen. Es ist noch ein Weg zu gehen, damit dieses Tool wettbewerbsfähig wird, was nicht weit entfernt ist. Sie könnten auf grundlegende betriebliche Herausforderungen stoßen.

Pentaho

Pentaho ist ein weiteres Datenmigrations- und Integrationstool, das wiederum über kommerzielle und Open-Source-Versionen verfügt, mit denen Daten aus jeder Datenquelle in jede Datenbank migriert werden können. Dies ist auch eine Option, um Daten nach PostgreSQL zu migrieren. Dieses Tool unterstützt eine breite Palette von Datenbanken und arbeitet auf einem größeren Raum mit Datenvisualisierungsfunktionen.

Vorteile: Pentaho ist ein Java-basiertes Tool, es arbeitet im GUI-Modus und kann auf Betriebssystemen wie Windows, Unix und Linux ausgeführt werden. Arbeitet auf einem viel größeren Raum und eignet sich sehr gut für Datentransformations- und Visualisierungszwecke. Wie oben erwähnt, unterstützt eine breite Palette von Datenspeichern.

Nachteile: ist kein einfaches Tool, das einfach Daten extrahieren und in die Zieldatenbank laden kann. Der Datenmigrationsprozess kann komplex und zeitaufwändig sein. Konzentriert sich stark auf Datentransformation, -bereinigung, -integration und -visualisierung. Das Tool ist keine gute Wahl, um Daten ohne Datentransformationen oder Bereinigungsübungen einfach von einer Datenbank in eine andere Datenbank zu migrieren. Die Leistung kann bei der Migration großer Datenmengen eine Herausforderung darstellen.

Individuell erstelltes ETL: Es ist keine Übertreibung zu sagen, dass benutzerdefinierte ETLs eine der gängigsten Methoden sind, um einen durchgängig effizienten und hochleistungsfähigen ETL-Prozess zu erreichen. DBAs und Entwickler, die in diese Situation geraten, sind keine Überraschung. Für ein einzelnes ETL wäre es unmöglich, die Datenkomplexität, Datenform und Umweltherausforderungen zu verstehen. Beispiel:Wenn Sie Daten aus mehreren unterschiedlichen Datenbanken in einem Rechenzentrum mit komplexen Datenmodellen zu einer PostgreSQL-Datenbank migrieren, die in einem anderen Rechenzentrum oder einer öffentlichen Cloud gehostet wird. In einer solchen Situation kann die Jagd nach dem besten ETL in einer wilden Verfolgungsjagd enden. Wenn Sie also einen umgebungsspezifischen und datenspezifischen ETL-Prozess erstellen möchten, ist die Wahl von benutzerdefiniertem ETL der richtige Weg.

Vorteile: Eine sehr gute Alternative für Organisationen mit komplexen Umgebungen und komplexen Daten, in denen es einfach nicht möglich ist, eine ETL zu finden, die alle Ihre Datenmigrationsbelange anspricht. Kann in Bezug auf Funktionalität und Leistung sehr vorteilhaft sein. Kann Zeit und Kosten reduzieren, wenn es um die Behebung von Fehlern und Defekten im Tool geht. Kritische, komplexe und stark gebundene ETL-Operationen können hochleistungsfähig und zuverlässig gemacht werden, da die Entwickler die volle Kontrolle über das Tool haben. Flexibilität kennt keine Grenzen. Ist eine gute Option, wenn Sie nach Funktionen suchen, die über ETL-Tools hinausgehen, und kann jede Komplexitätsstufe ansprechen. Wenn Sie sich für Technologien wie Java oder Python entschieden haben, um benutzerdefinierte ETL zu erstellen, lassen sie sich sehr gut mit PostgreSQL kombinieren.

Nachteile: Das Erstellen einer benutzerdefinierten ETL kann extrem zeitaufwändig sein. Es sind erhebliche Design- und Entwicklungsanstrengungen erforderlich, um alle Datenmigrationsanforderungen und andere Datenherausforderungen zu bewältigen. Im Folgenden sind einige der Herausforderungen aufgeführt, mit denen benutzerdefinierte ETLs Schritt halten müssen, was erheblichen Entwicklungsaufwand und Zeit für Verbesserungen erfordern kann:

- Umgebungsänderungen

- Änderungen der Infrastruktur- und Datenbankarchitektur mit Auswirkungen auf den ETL-Betrieb

- Änderungen des Datentyps

- Wachstum des Datenvolumens, das sich erheblich auf die Leistung der Datenmigration auswirkt

- Änderungen der Schemastruktur oder des Designs

- Jede kritische Codeänderung an der ETL muss entwickelt und getestet werden, bevor sie in die Produktion geht, dies kann viel Zeit in Anspruch nehmen

Im Allgemeinen werden ETL-Entwicklungen nicht als kritischer Teil des Projektbudgets angesehen, da sie nicht Teil der regulären Geschäftsanwendungen oder des Datenbankentwicklungsprozesses sind. Es ist keine Überraschung, wenn Unternehmen sich nicht dafür entscheiden, ein benutzerdefiniertes ETL zu erstellen, wenn Budget-, Ressourcen- oder Zeitprobleme auftauchen.

Was ist das beste ETL-Tool?

Nun, darauf gibt es keine einfache Antwort. Es hängt alles von Ihren Anforderungen und der Umgebung ab. Die Auswahl eines ETL für die Migration von Daten zu PostgreSQL hängt von verschiedenen Faktoren ab. Sie müssen die Faktoren verstehen, die sich auf die Datenmigration auswirken. Unten sind die meisten von ihnen...

- Ihre Daten verstehen

- Komplexität der Daten

- Datentypen

- Datenquelle

- Datengröße

- Wie sind die Quelldaten? in einer Datenbank? in einer flachen Datei? Strukturiert oder unstrukturiert? usw.. usw..

- Welche Schritte wird Ihre Datenmigration umfassen? Ihre Erwartungen an das Tool.

Wenn Sie die oben genannten Punkte kennen, sind Sie fast in der Lage, sich für ein ETL-Tool zu entscheiden. Die Analyse der oben genannten Faktoren würde Ihnen helfen, die Eigenschaften und Fähigkeiten der einzelnen ETL-Tools zu bewerten. Technische Experten, die eine Datenmigration durchführen, würden im Allgemeinen nach einem ETL-Tool suchen, das effizient, flexibel und hochleistungsfähig ist.

Letztendlich ist es keine Überraschung, wenn Sie am Ende mehrere ETL-Tools auswählen oder sogar selbst ein benutzerdefiniertes Tool entwickeln.

Ehrlich gesagt ist es schwierig, nur ein ETL-Tool zu empfehlen, ohne Ihre Datenanforderungen zu kennen. Stattdessen würde ich vorschlagen, dass ein Tool die folgenden Merkmale aufweisen sollte, um einen effizienten und hochleistungsfähigen Datenmigrationsprozess zu entwerfen...

- Muss Textschnittstelle mit genügend Konfigurationsoptionen verwenden

- Muss in der Lage sein, große Datenmengen effizient zu migrieren, indem mehrere CPUs und der Arbeitsspeicher effektiv genutzt werden

- Es wäre gut, wenn das Tool auf mehreren Betriebssystemen installiert werden könnte. Einige PostgreSQL-spezifische Tools unterstützen nur Windows, was aus Kosten-, Effizienz- und Leistungssicht herausfordernd sein kann

- Muss in der Lage sein, die Quelldaten und die Zieldatenbank zu verstehen

- Muss flexible Konfigurationsoptionen mit genügend Kontrolle haben, um das Tool in ein Bash- oder Python-Skript einzubinden, anzupassen und mehrere Jobs parallel zu planen

- Ein optimaler Testprozess muss entwickelt werden, um die Datenmigrationsfähigkeiten des Tools zu verstehen

Es gibt GUI-Tools, die einfach einzurichten sind und die Daten mit einem Klick migrieren. Diese Tools eignen sich gut für die Migration von Daten angemessener Größe in Nicht-Cloud-Umgebungen und sind stark von der Infrastruktur und der Hardwarekapazität abhängig. Es wird nicht viele Optionen geben, außer die Infra-Fähigkeit für eine schnellere Datenmigration zu erhöhen, und Optionen zum Ausführen mehrerer Jobs sind ebenfalls düster.

Beim Migrieren von Daten nach PostgreSQL würde ich zuerst auf Talend oder SQLines schauen. Wenn ich die Daten von Oracle migrieren muss, würde ich mir Ora2pg ansehen.