Hier ist eine speicherfreundliche Funktion, die in der Lage sein sollte, eine große Datei in einzelne Abfragen aufzuteilen, ohne die gesamte Datei auf einmal öffnen zu müssen :

function SplitSQL($file, $delimiter = ';')

{

set_time_limit(0);

if (is_file($file) === true)

{

$file = fopen($file, 'r');

if (is_resource($file) === true)

{

$query = array();

while (feof($file) === false)

{

$query[] = fgets($file);

if (preg_match('~' . preg_quote($delimiter, '~') . '\s*$~iS', end($query)) === 1)

{

$query = trim(implode('', $query));

if (mysql_query($query) === false)

{

echo '<h3>ERROR: ' . $query . '</h3>' . "\n";

}

else

{

echo '<h3>SUCCESS: ' . $query . '</h3>' . "\n";

}

while (ob_get_level() > 0)

{

ob_end_flush();

}

flush();

}

if (is_string($query) === true)

{

$query = array();

}

}

return fclose($file);

}

}

return false;

}

Ich habe es auf einem großen phpMyAdmin-SQL-Dump getestet und es hat gut funktioniert.

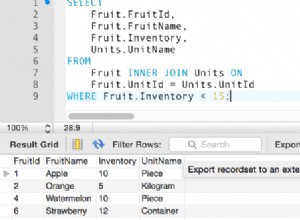

Einige Testdaten:

CREATE TABLE IF NOT EXISTS "test" (

"id" INTEGER PRIMARY KEY AUTOINCREMENT,

"name" TEXT,

"description" TEXT

);

BEGIN;

INSERT INTO "test" ("name", "description")

VALUES (";;;", "something for you mind; body; soul");

COMMIT;

UPDATE "test"

SET "name" = "; "

WHERE "id" = 1;

Und die jeweilige Ausgabe:

SUCCESS: CREATE TABLE IF NOT EXISTS "test" ( "id" INTEGER PRIMARY KEY AUTOINCREMENT, "name" TEXT, "description" TEXT );

SUCCESS: BEGIN;

SUCCESS: INSERT INTO "test" ("name", "description") VALUES (";;;", "something for you mind; body; soul");

SUCCESS: COMMIT;

SUCCESS: UPDATE "test" SET "name" = "; " WHERE "id" = 1;