Nein. Sie können Schemas in JSON-Einträgen aktivieren. Die JDBC-Quelle kann sie für Sie erstellen basierend auf den Tabelleninformationen

value.converter=org.apache.kafka...JsonConverter

value.converter.schemas.enable=true

Wenn Sie die Schemaregistrierung verwenden möchten, sollten Sie kafkastore.bootstrap.servers verwenden .mit der Kafka-Adresse, nicht Zookeeper. Entfernen Sie also kafkastore.connection.url

Bitte lesen Sie die Dokumentation für Erklärungen aller Eigenschaften

Egal. Das Schemas-Thema wird erstellt, wenn die Registrierung zum ersten Mal gestartet wird

Ja (ohne Berücksichtigung des verfügbaren JVM-Heap-Speicherplatzes). Auch dies wird in der Kafka Connect-Dokumentation ausführlich beschrieben.

Im Standalone-Modus übergeben Sie zuerst die Connect-Worker-Konfiguration und dann bis zu N Connector-Eigenschaften in einem Befehl

Im verteilten Modus verwenden Sie die Kafka Connect-REST-API

https://docs.confluent.io/current/connect/managing/configuring .html

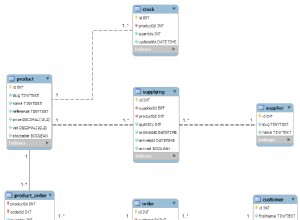

Zunächst einmal gilt das für Sqlite, nicht für Mysql/Postgres. Sie müssen die Schnellstartdateien nicht verwenden, sie dienen nur als Referenz

Auch hier sind alle Eigenschaften gut dokumentiert

https://docs.confluent.io /current/connect/kafka-connect-jdbc/index.html#connect-jdbc

Hier finden Sie weitere Informationen darüber, wie Sie das beheben können

https://www.confluent.io/ blog/kafka-connect-deep-dive-jdbc-source-connector/

Wie bereits erwähnt, würde ich persönlich vorschlagen, wenn möglich, Debezium/CDC zu verwenden

Debezium Connector für RDS Aurora