In diesem Big Data Hadoop-Tutorial , stellen wir Ihnen eine detaillierte Beschreibung des Hadoop HDFS-Datenblocks zur Verfügung. Zunächst werden wir behandeln, was Datenblöcke in Hadoop sind, welche Bedeutung sie haben und warum die Größe von HDFS-Datenblöcken 128 MB beträgt.

Wir werden auch das Beispiel von Datenblöcken in Hadoop und verschiedene Vorteile von HDFS in Hadoop diskutieren.

Einführung in den HDFS-Datenblock

Hadoop-HDFS Teilen Sie große Dateien in kleine Stücke auf, die als Blöcke bekannt sind . Block ist die physische Darstellung von Daten. Es enthält eine Mindestmenge an Daten, die gelesen oder geschrieben werden können. HDFS speichert jede Datei als Blöcke. Der HDFS-Client hat keine Kontrolle über den Block wie die Blockposition, Namenode entscheidet über all diese Dinge.

Standardmäßig beträgt die HDFS-Blockgröße 128 MB die Sie nach Ihren Wünschen ändern können. Alle HDFS-Blöcke haben dieselbe Größe, mit Ausnahme des letzten Blocks, der entweder dieselbe Größe oder kleiner sein kann.

Das Hadoop-Framework zerlegt Dateien in 128-MB-Blöcke und speichert sie dann im Hadoop-Dateisystem. Die Apache Hadoop-Anwendung ist für die Verteilung des Datenblocks auf mehrere Knoten verantwortlich.

Beispiel-

Angenommen, die Dateigröße beträgt 513 MB und wir verwenden die Standardkonfiguration mit einer Blockgröße von 128 MB. Dann erstellt das Hadoop-Framework 5 Blöcke, die ersten vier Blöcke haben 128 MB, aber der letzte Block hat nur 1 MB.

Aus dem Beispiel geht also hervor, dass es nicht erforderlich ist, dass in HDFS jede gespeicherte Datei ein exaktes Vielfaches der konfigurierten Blockgröße von 128 MB, 256 MB usw. sein muss. Daher verwendet der endgültige Block für die Datei nur so viel Speicherplatz wie erforderlich.

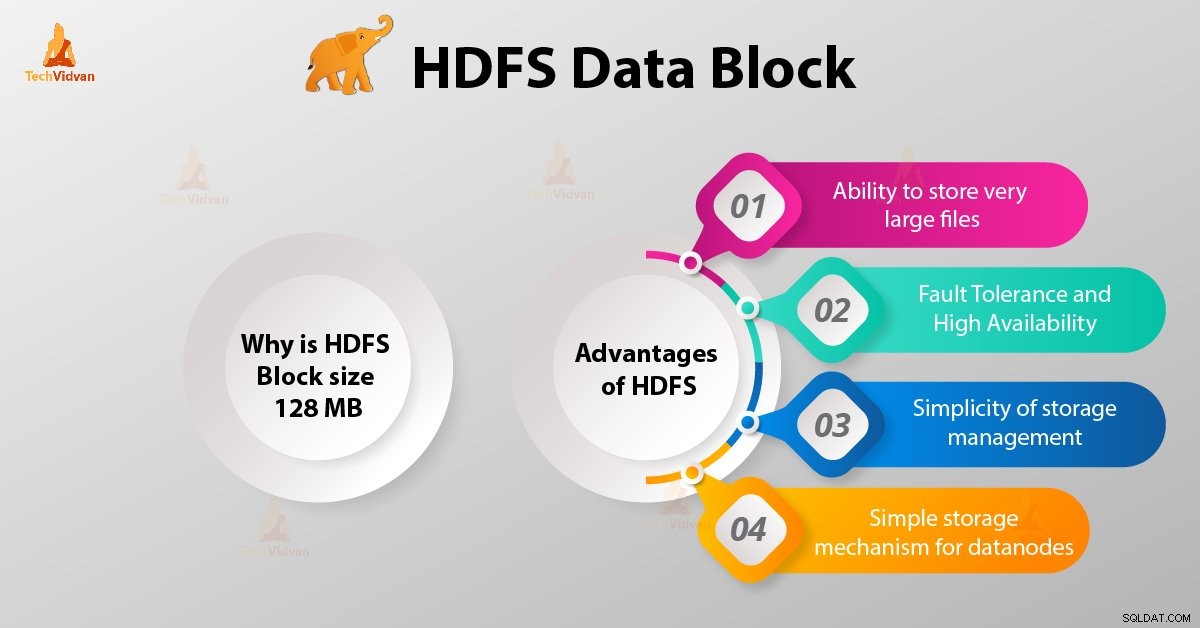

Warum beträgt die HDFS-Blockgröße 128 MB?

HDFS speichert Terabytes und Petabytes an Daten. Wenn die HDFS-Blockgröße wie beim Linux-Dateisystem 4 KB beträgt, haben wir zu viele Datenblöcke in Hadoop HDFS und damit zu viele Metadaten.

Die Pflege und Verwaltung dieser riesigen Anzahl von Blöcken und Metadaten wird also einen enormen Overhead und Datenverkehr verursachen, was wir nicht wollen.

Die Blockgröße kann nicht so groß sein, dass das System sehr lange darauf wartet, dass eine letzte Einheit der Datenverarbeitung ihre Arbeit beendet.

Vorteile von HDFS

Nachdem wir gelernt haben, was HDFS Data Block ist, wollen wir nun die Vorteile von Hadoop HDFS besprechen.

1. Fähigkeit, sehr große Dateien zu speichern

Hadoop HDFS speichert sehr große Dateien, die sogar größer als die Größe einer einzelnen Festplatte sind, da das Hadoop-Framework Dateien in Blöcke aufteilt und auf verschiedene Knoten verteilt.

2. Fehlertoleranz und Hochverfügbarkeit von HDFS

Das Hadoop-Framework kann Blöcke problemlos zwischen den Datenknoten replizieren. Sorgen Sie daher für Fehlertoleranz und hohe Verfügbarkeit HDFS.

3. Einfachheit der Speicherverwaltung

Da HDFS eine feste Blockgröße (128 MB) hat, ist es sehr einfach, die Anzahl der Blöcke zu berechnen, die auf der Festplatte gespeichert werden können.

4. Einfacher Speichermechanismus für Datenknoten

Block in HDFS vereinfacht die Speicherung der Datanodes . Namensknoten verwaltet Metadaten aller Blöcke. HDFS Datanode muss sich nicht um die Block-Metadaten wie Dateiberechtigungen usw. kümmern.

Schlussfolgerung

Daher ist der HDFS-Datenblock die kleinste Dateneinheit in einem Dateisystem. Die Standardgröße des HDFS-Blocks beträgt 128 MB, die Sie nach Bedarf konfigurieren können. HDFS-Blöcke lassen sich einfach zwischen den Datenknoten replizieren. Bieten Sie daher Fehlertoleranz und Hochverfügbarkeit von HDFS.

Bei Fragen oder Vorschlägen zu Hadoop HDFS-Datenblöcken teilen Sie uns dies bitte mit, indem Sie einen Kommentar in einem der unten angegebenen Abschnitte hinterlassen.