Die digitale Transformation ist ein heißes Thema für alle Märkte und Branchen, da sie mit explosiven Wachstumsraten Mehrwert liefert. Bedenken Sie, dass das Internet der Dinge (IIOT) der Fertigungsindustrie auf 161 Milliarden US-Dollar mit einer beeindruckenden Wachstumsrate von 25 % geschätzt wurde, der Connected-Car-Markt wird bis 2027 mit einer Wachstumsrate von 17 % auf 225 Milliarden US-Dollar geschätzt, oder das in den ersten drei Monaten von 2020 haben Einzelhändler in nur drei Monaten zehn Jahre digitale Vertriebsdurchdringung realisiert. Das meiste, was geschrieben wird, hat jedoch mit den unterstützenden Technologieplattformen (Cloud- oder Edge- oder Punktlösungen wie Data Warehouses) oder Anwendungsfällen zu tun, die diese Vorteile vorantreiben (prädiktive Analytik für vorbeugende Wartung, Betrugserkennung von Finanzinstituten oder prädiktive Gesundheitsüberwachung). als Beispiele) nicht die zugrunde liegenden Daten. Im fehlenden Kapitel geht es nicht um Punktlösungen oder die Reifereise von Use Cases. Das fehlende Kapitel dreht sich um die Daten – es geht immer um die Daten – und vor allem um die Reisedaten, die vom Edge bis zu den Erkenntnissen der künstlichen Intelligenz verwoben sind.

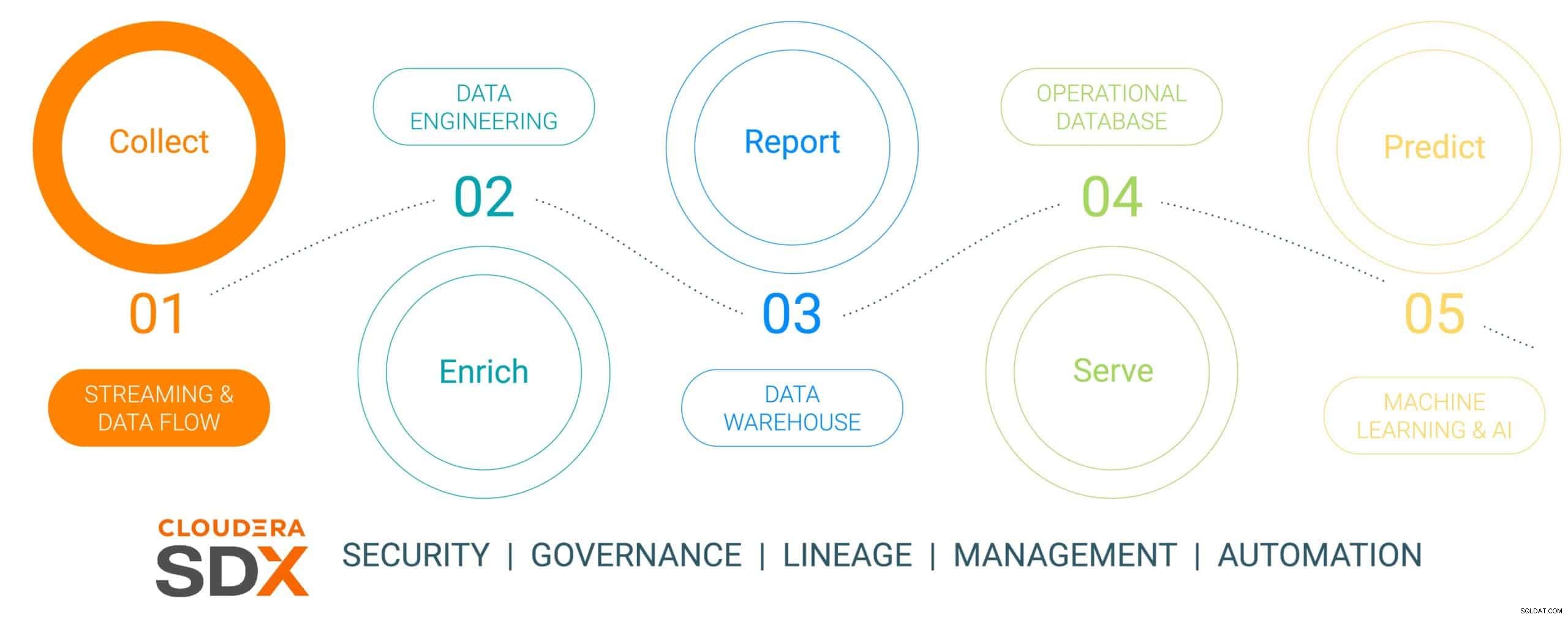

Dies ist der erste Teil einer sechsteiligen Blogserie, die den Weg der Daten vom Edge zur KI und den Geschäftswert beschreibt, den Daten auf diesem Weg erzeugen. Die Datenreise ist nicht linear, sondern ein Datenlebenszyklus in Endlosschleife – der an der Edge beginnt, sich durch eine Datenplattform bewegt und zu geschäftskritischen Erkenntnissen führt, die auf echte geschäftskritische Probleme angewendet werden, die zu neuen datengesteuerten Initiativen führen. Wir haben diese Reise in fünf diskrete Schritte vereinfacht, wobei ein gemeinsamer sechster Schritt die Datensicherheit und Governance betrifft. Die sechs Schritte sind:

- Datenerhebung – Datenaufnahme und -überwachung am Edge (unabhängig davon, ob es sich bei dem Edge um Industriesensoren oder Menschen in einem stationären Einzelhandelsgeschäft handelt)

- Datenanreicherung – Verarbeitung, Aggregation und Verwaltung von Datenpipelines, um die Daten für die weitere Verfeinerung vorzubereiten

- Berichte – Bereitstellung von Unternehmenseinblicken (Verkaufsanalysen und -prognosen, Marktforschung, Budgetierung als Beispiele)

- Servieren – Steuerung und Ausführung wesentlicher Geschäftsvorgänge (Geldautomatentransaktionen, Kassen im Einzelhandel oder Produktionsüberwachung)

- Predictive Analytics – Predictive Analytics basierend auf KI und maschinellem Lernen (Fraud Detection, Predictive Maintenance, Demand Based Inventory Optimization als Beispiele)

- Sicherheit und Verwaltung – eine integrierte Reihe von Sicherheits-, Management- und Governance-Technologien über den gesamten Datenlebenszyklus

Abb. 1:Der Unternehmensdatenlebenszyklus

Um die Datenreise zu veranschaulichen, haben wir ein sehr relevantes und nachhaltig ausgerichtetes Fertigungsthema ausgewählt – die Herstellung eines Elektroautos, das ausgewählt wurde, weil die Fertigungsvorgänge in der Regel revolutionärer Natur sind (hohe digitale Reife durch den Einsatz der aktuellsten Datenwerkzeuge). , im Vergleich zu „old-school evolutionary“ (von geringerem Reifegrad) und dass die meisten dieser Autos als Connected Mobility-Plattformen gebaut werden, wodurch das Auto mehr als nur ein Transportmittel ist, sondern eine Plattform für datengestütztes Wissen und Erkenntnisse. Diese Geschichte zeigt, wie Daten mithilfe der Cloudera Data Platform gesammelt, angereichert, gespeichert, bereitgestellt und dann verwendet werden, um Ereignisse im Herstellungsprozess des Autos vorherzusagen.

In dieser Geschichte geht es um eine nachgebildete Firma zur Herstellung vernetzter Elektrofahrzeuge namens (mit einem höchst originellen Namen) The Electric Car Company (ECC). ECC betreibt mehrere Produktionsstätten auf der ganzen Welt, ist vertikal integriert und baut seine eigenen Autos sowie viele der kritischen Komponenten, darunter Elektromotoren, Batterien und Hilfsteile. Jede Fabrik ist mit der Herstellung verschiedener Komponenten beauftragt, wobei die Endmontage in einigen ausgewählten, strategisch günstig gelegenen Fabriken stattfindet.

Datenerfassungs-Challenge

Die Verwaltung der Sammlung aller Daten aus allen Fabriken im Herstellungsprozess ist ein bedeutendes Unterfangen, das einige Herausforderungen mit sich bringt:

- Schwierigkeit bei der Einschätzung des Umfangs und der Vielfalt von IoT-Daten: Viele Fabriken nutzen sowohl moderne als auch ältere Fertigungsanlagen und -geräte von mehreren Anbietern mit verschiedenen Protokollen und Datenformaten. Obwohl die Steuerungen und Geräte mit einem OT-System verbunden sein können, sind sie normalerweise nicht so verbunden, dass sie die Daten auch problemlos mit IT-Systemen teilen können. Um eine vernetzte Fertigung und aufkommende IoT-Anwendungsfälle zu ermöglichen, benötigt ECC eine Lösung, die alle Arten unterschiedlicher Datenstrukturen und -schemata von der Edge verarbeiten, die Daten normalisieren und sie dann mit jeder Art von Datenverbraucher, einschließlich Big-Data-Anwendungen, teilen kann.

- Verwaltung der Komplexität von Echtzeitdaten: Damit ECC prädiktive Analyseanwendungsfälle vorantreiben kann, muss eine Datenverwaltungsplattform Echtzeitanalysen von Streaming-Daten ermöglichen. Die Plattform muss die Streaming-Daten auch effektiv in Echtzeit oder nahezu in Echtzeit aufnehmen, speichern und verarbeiten, um sofort Erkenntnisse und Maßnahmen zu liefern.

- Befreiung von Daten aus unabhängigen Silos: Spezialisierte Prozesse (Innovationsplattformen, QMS, MES usw.) innerhalb der Wertschöpfungskette der Fertigung belohnen unterschiedliche Datenquellen und Datenverwaltungsplattformen, die auf einzigartige Insellösungen zugeschnitten sind. Diese Nischenlösungen schränken den Unternehmenswert ein, da sie nur einen Bruchteil der Einblicke berücksichtigen, die unternehmensübergreifende Daten bieten können, während sie das Geschäft aufteilen und die Möglichkeiten der Zusammenarbeit einschränken. Die richtige Plattform muss in der Lage sein, Streaming-Daten von allen Punkten der Wertschöpfungskette aufzunehmen, zu speichern, zu verwalten, zu analysieren und zu verarbeiten, sie mit Datenhistorikern, ERP-, MES- und QMS-Quellen zu kombinieren und sie in umsetzbare Erkenntnisse umzuwandeln. Diese Erkenntnisse liefern Dashboards, Berichte und prädiktive Analysen, die hochwertige Anwendungsfälle in der Fertigung vorantreiben.

- Ausgleich der Kante: Es ist eine Herausforderung, das richtige Gleichgewicht zwischen der Datenverarbeitung am Edge und in der Cloud zu finden, und deshalb muss der gesamte Datenlebenszyklus berücksichtigt werden. Es gibt einen besorgniserregenden Trend in der Branche, da Unternehmen sich entweder auf das eine oder das andere konzentrieren, ohne zu erkennen, dass sie beides können und sollten. Cloud Computing hat seine Vorteile für langfristige Analysen und den groß angelegten Einsatz, ist jedoch durch die Bandbreite begrenzt und sammelt oft große Datenmengen, während nur ein kleiner Teil verwendet wird. Der Wert der Edge liegt darin, an der Edge zu agieren, wo sie die größte Wirkung ohne Latenz hat, bevor sie die wertvollsten Daten zur weiteren Hochleistungsverarbeitung an die Cloud sendet.

Datenerhebung mithilfe der Cloudera-Datenplattform

SCHRITT 1:Sammeln der Rohdaten

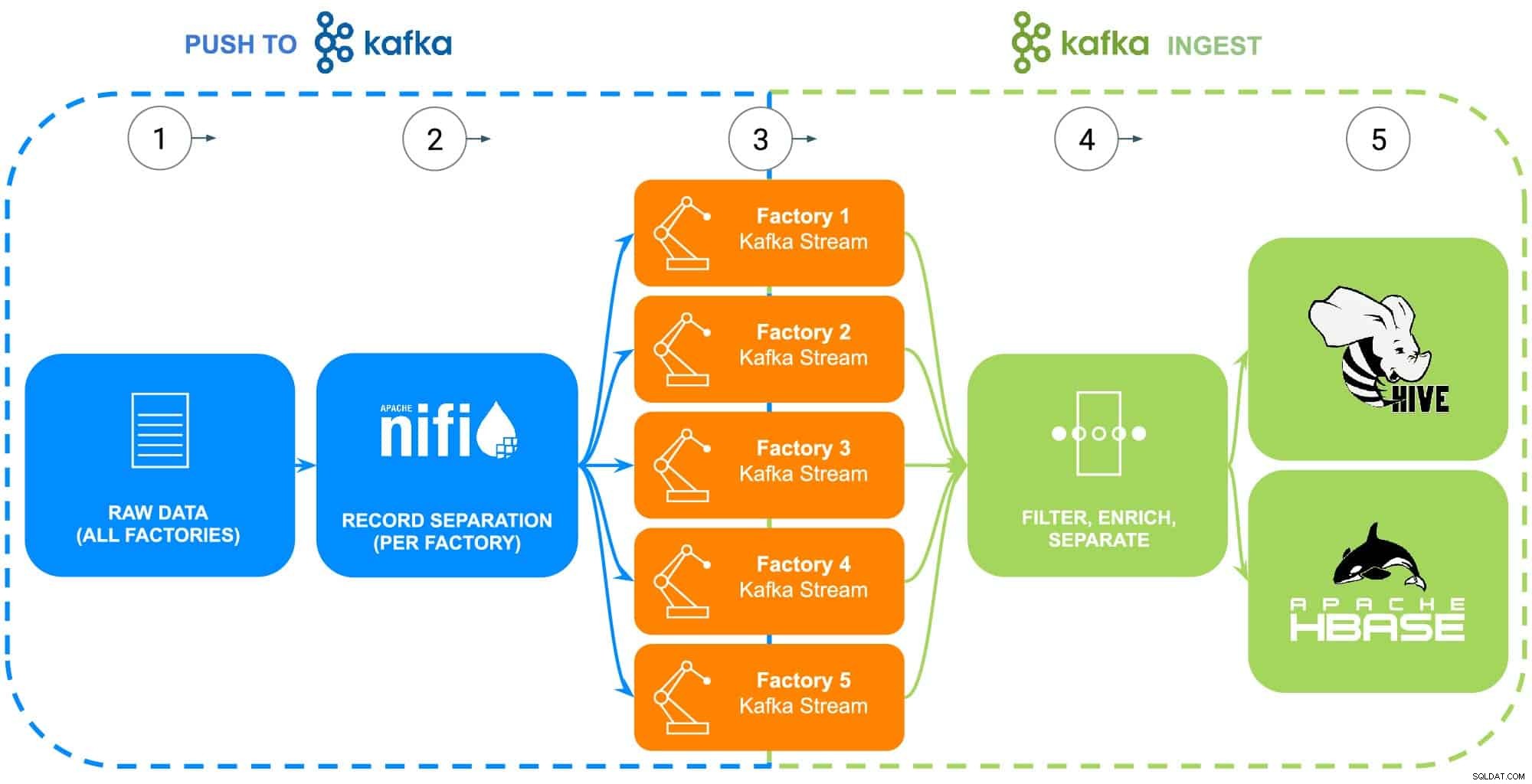

Daten aus dem Fertigungsbetrieb von ECC umfassen eine Vielzahl von Quellen – Industrieroboter, Rohkarosserie-Phosphatbeschichtungs-Prozesstanks (Temperatur, Konzentration oder Nachschub), Lieferkettentelematik oder Stammteilinformationen usw. In diesem speziellen Beispiel das Rohteil Es wurden Stammdaten für jede der fünf Fabriken von ECC gesammelt, um sie an Apache NiFi weiterzuleiten (siehe Abb. 2).

SCHRITT 2:Datenquellen für jede Fabrik konfigurieren

Die Datenerfassung wird anhand der Data Flow-Erfahrung von Cloudera (unterstützt von Apache NiFi) veranschaulicht, um diese Rohdaten abzurufen und sie in einzelne Factory-Streams (verwaltet von Apache Kafka) aufzuteilen, um einem realen Szenario genauer zu entsprechen (siehe Abb. 2). Um das Beispiel einfach zu halten, wurden die folgenden Datenattribut-Tags für jedes von den Fabriken generierte Teil ausgewählt:

- Werks-ID

- Maschinen-ID

- Hergestellter Zeitstempel

- Teilenummer

- Seriennummer

Abb. 2:Flussdiagramm der Datensammlung.

SCHRITT 3:Überwachen Sie den Datendurchsatz von jeder Fabrik

Da alle Daten jetzt in einzelne Kafka-Streams fließen, überwacht ein Datenarchitekt den Datendurchsatz von jeder Fabrik und passt die erforderlichen Rechen- und Speicherressourcen an, um sicherzustellen, dass jede Fabrik über den erforderlichen Durchsatz verfügt, um Daten an die Plattform zu senden.

SCHRITT 4:Erfassen Sie Daten aus Apache Kafka-Streams

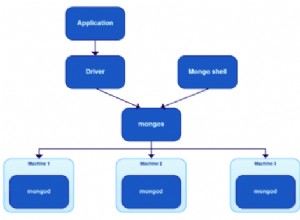

Kafka erfasst alle Fabrikdatenströme und sammelt sie in Prozessoren, die sowohl filtern als auch anreichern, um wichtige Geschäftsvorgänge zu steuern und auszuführen, die von einer Betriebsdatenbank unterstützt werden, oder um Einblicke in das Unternehmen über ein Enterprise Data Warehouse zu liefern oder in erweiterten Analysen zu verwenden.

ECC hat kürzlich mit der Produktion einer aktualisierten Version ihres Elektromotors begonnen, der nur in Fabrik 5 produziert wird. Diese Daten werden als Veranschaulichung der nächsten Schritte im Datenlebenszyklus verwendet.

SCHRITT 5:Daten an Speicherlösungen übertragen

Da die ECC-Fertigungs- und Qualitätsingenieure den Einsatz und den Feldeinsatz dieses Motors genau überwachen möchten, werden die spezifischen Rückverfolgbarkeitsdaten der Fertigung in eine separate Route gefiltert und in einer eigenen Tabelle in Apache Hive gespeichert. Auf diese Weise können die Ingenieure später Ad-hoc-Abfragen in Cloudera Data Warehouse gegen die Daten ausführen und sie mit anderen relevanten Daten im Unternehmens-Data Warehouse verknüpfen, z. B. Reparaturaufträgen oder Kundenfeedback, um erweiterte Anwendungsfälle wie Garantie und Vorhersage zu erstellen Wartungsroutinen oder Beiträge zur Produktentwicklung.

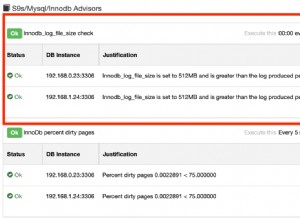

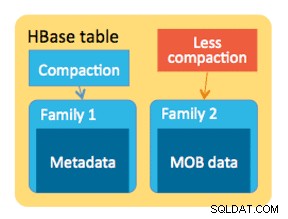

Wenn alternativ wesentliche Geschäftsvorgänge gesteuert und ausgeführt werden sollen, wird der gesamte Datensatz mit dem Zusatz eines verarbeiteten Zeitstempels an die von Apache HBase betriebene Cloudera Operational Database gesendet. Diese Daten dienen ECC als Grundlage für den Betrieb ihrer Bestandsplattform, die die Verwendung konstanter Lese-/Schreibvorgänge erfordert, da Bestand tausende Male pro Tag hinzugefügt und entfernt werden kann. Da HBase darauf ausgelegt ist, diese Art von Datentransaktionen in großem Umfang zu handhaben, ist es die beste Lösung für diese einzigartige Herausforderung.

Schlussfolgerung

Diese einfache Illustration zeigt, wie wichtig es ist, die Datenaufnahme richtig zu machen, da sie die Grundlage für Erkenntnisse bildet, die sowohl aus operativen Datenbanken, Unternehmens-Data Warehouses als auch aus fortschrittlichen vorausschauenden analytischen maschinellen Lernanalysen stammen. Der Wert, „es richtig zu machen“, beinhaltet die Verwendung von Daten aus beliebigen Unternehmensquellen, wodurch Datensilos aufgebrochen werden, alle Daten verwendet werden, ob Streaming- oder Batch-orientiert, und die Möglichkeit, diese Daten an die richtige Stelle zu senden, um die gewünschten Downstream-Einblicke zu erhalten.

Mithilfe von CDP können ECC-Dateningenieure und andere Branchenbenutzer damit beginnen, gesammelte Daten für verschiedene Aufgaben zu verwenden, die von der Bestandsverwaltung über Teileprognosen bis hin zu maschinellem Lernen reichen. Da Cloudera Data Flow die Datenaufnahme in Echtzeit aus beliebigen Unternehmensquellen fördert, kann es ohne umfassende Kenntnisse verschiedener Programmiersprachen und proprietärer Datenerfassungsmethoden erweitert und gewartet werden. Wenn einzigartige Probleme auftreten, können Ingenieure auch ihre eigenen Prozesse für eine wirklich feinkörnige Kontrolle erstellen.

Suchen Sie nach dem nächsten Blog, der sich mit der Datenanreicherung befasst und wie sie die Geschichte des Datenlebenszyklus unterstützt. Darüber hinaus wird diese Geschichte durch datengesteuerte Demos ergänzt, die die Reise der Daten durch jeden Schritt des Datenlebenszyklus zeigen.

Weitere Ressourcen zur Datenerfassung

Um all dies in Aktion zu sehen, klicken Sie bitte auf die entsprechenden Links unten, um mehr über die Datenerfassung zu erfahren:

- Video – Wenn Sie sehen und hören möchten, wie dies gebaut wurde, sehen Sie sich das Video unter dem Link an.

- Tutorials – Wenn Sie dies in Ihrem eigenen Tempo tun möchten, sehen Sie sich eine detaillierte exemplarische Vorgehensweise mit Screenshots und zeilenweisen Anweisungen zum Einrichten und Ausführen an.

- Meetup – Wenn Sie direkt mit Experten von Cloudera sprechen möchten, nehmen Sie bitte an einem virtuellen Meetup teil, um eine Live-Stream-Präsentation zu sehen. Am Ende ist Zeit für direkte Fragen und Antworten.

- Benutzer – Klicken Sie auf den Link, um weitere technische Inhalte speziell für Benutzer anzuzeigen.