TL;DR: LOAD DATA INFILE ist eine Größenordnung schneller als mehrere INSERT -Anweisungen, die selbst eine Größenordnung schneller sind als einzelne INSERT Aussagen.

Im Folgenden bewerte ich die drei Hauptstrategien zum Importieren von Daten aus R in Mysql:

-

einzelne

insertAussagen , wie in der Frage:INSERT INTO test (col1,col2,col3) VALUES (1,2,3) -

mehrere

insertAussagen , wie folgt formatiert:INSERT INTO test (col1,col2,col3) VALUES (1,2,3),(4,5,6),(7,8,9) -

load data infileErklärung , d.h. Laden einer zuvor geschriebenen CSV-Datei inmysql:LOAD DATA INFILE 'the_dump.csv' INTO TABLE test

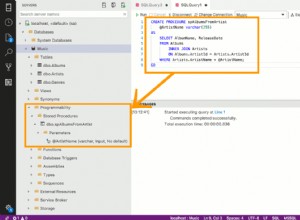

Ich verwende RMySQL hier, aber jeder andere MySQL-Treiber sollte zu ähnlichen Ergebnissen führen. Die SQL-Tabelle wurde instanziiert mit:

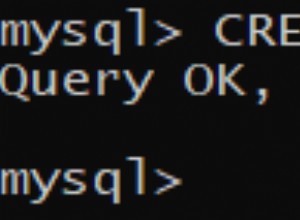

CREATE TABLE `test` (

`col1` double, `col2` double, `col3` double, `col4` double, `col5` double

) ENGINE=MyISAM;

Die Verbindungs- und Testdaten wurden in R erstellt mit:

library(RMySQL)

con = dbConnect(MySQL(),

user = 'the_user',

password = 'the_password',

host = '127.0.0.1',

dbname='test')

n_rows = 1000000 # number of tuples

n_cols = 5 # number of fields

dump = matrix(runif(n_rows*n_cols), ncol=n_cols, nrow=n_rows)

colnames(dump) = paste0('col',1:n_cols)

Benchmarking einzelner insert Aussagen:

before = Sys.time()

for (i in 1:nrow(dump)) {

query = paste0('INSERT INTO test (',paste0(colnames(dump),collapse = ','),') VALUES (',paste0(dump[i,],collapse = ','),');')

dbExecute(con, query)

}

time_naive = Sys.time() - before

=> Dies dauert etwa 4 Minuten auf meinem Computer

Benchmarking mehrerer insert Aussagen:

before = Sys.time()

chunksize = 10000 # arbitrary chunk size

for (i in 1:ceiling(nrow(dump)/chunksize)) {

query = paste0('INSERT INTO test (',paste0(colnames(dump),collapse = ','),') VALUES ')

vals = NULL

for (j in 1:chunksize) {

k = (i-1)*chunksize+j

if (k <= nrow(dump)) {

vals[j] = paste0('(', paste0(dump[k,],collapse = ','), ')')

}

}

query = paste0(query, paste0(vals,collapse=','))

dbExecute(con, query)

}

time_chunked = Sys.time() - before

=> Dies dauert ca. 40 Sekunden auf meinem Computer

Benchmarking load data infile Erklärung :

before = Sys.time()

write.table(dump, 'the_dump.csv',

row.names = F, col.names=F, sep='\t')

query = "LOAD DATA INFILE 'the_dump.csv' INTO TABLE test"

dbSendStatement(con, query)

time_infile = Sys.time() - before

=> Dies dauert ca. 4 Sekunden auf meinem Computer

Die einfachste Möglichkeit, die Leistung zu verbessern, besteht darin, Ihre SQL-Abfrage so zu gestalten, dass sie viele Einfügewerte verarbeitet. Übergang zu LOAD DATA INFILE wird zu optimalen Ergebnissen führen. Tipps zur guten Leistung finden Sie auf dieser Seite der MySQL-Dokumentation .