Technologische Fortschritte haben zu Vorteilen geführt, die von Geschäftsorganisationen nicht genutzt werden müssen, um maximalen Gewinn zu erzielen und die Betriebskosten zu senken. Daten bilden das Rückgrat für diese technologischen Fortschritte, aus denen ausgeklügelte Verfahren zur Erreichung spezifischer Ziele abgeleitet werden. Mit fortschreitender Technologie werden mehr Daten in Systeme eingebracht. Wenn ein Unternehmen wächst, sind außerdem mehr Daten beteiligt, und das Serversystem muss eine schnelle Datenverarbeitung, eine zuverlässige Speicherung und eine optimale Sicherheit für diese Daten bieten. MongoDB ist eines der Systeme, denen man vertrauen kann, wenn es darum geht, diese Faktoren zu erreichen.

Big Data bezieht sich auf riesige Datenmengen, die sich schnell ändern, auf die schnell zugegriffen werden kann und die hochverfügbar sind, um Anforderungen effizient zu erfüllen. Unternehmensorganisationen neigen dazu, verfügbare Datenbank-Setups zu überprüfen, die im Laufe der Zeit die beste Leistung erbringen würden, und folglich einen gewissen Wert von Big Data zu realisieren.

Zum Beispiel beobachten Online-Märkte die Web-Klicks der Kunden, die Kaufkraft und verwenden dann die abgeleiteten Daten, um andere Waren als Werbemittel vorzuschlagen, oder verwenden die Daten bei der Preisgestaltung. Roboter lernen durch maschinelles Lernen, und bei diesem Prozess werden offensichtlich viele Daten gesammelt, da der Roboter das Gelernte für die spätere Verwendung im Gedächtnis behalten müsste. Es wird als unpraktisch angesehen, diese Art von komplexen Daten mit herkömmlicher Datenbanksoftware zu speichern.

Merkmale von Big Data

In Softwaresystemen betrachten wir Big Data hinsichtlich Größe, Zugriffsgeschwindigkeit und beteiligter Datentypen. Dies kann relativ auf drei Parameter reduziert werden:

- Lautstärke

- Geschwindigkeit

- Vielfalt

Lautstärke

Volumen ist die Größe der beteiligten Big Data und reicht von Gigabyte bis Terabyte oder mehr. Täglich nehmen große Unternehmen Terabytes an Daten aus ihrem täglichen Betrieb auf. Beispielsweise möchte ein Telekommunikationsunternehmen Aufzeichnungen über die seit Beginn des Betriebs getätigten Anrufe, die gesendeten Nachrichten und die Dauer jedes Anrufs führen. Täglich finden viele dieser Aktivitäten statt, was zu einer Menge Daten führt. Die Daten können für statistische Analysen, Entscheidungsfindung und Tarifplanung verwendet werden.

Geschwindigkeit

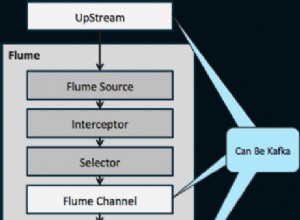

Berücksichtigen Sie Plattformen wie den Forex-Handel, die Echtzeit-Updates für alle angeschlossenen Client-Rechner benötigen und neue Börsenaktualisierungen in Echtzeit anzeigen. Dies schreibt vor, dass die bedienende Datenbank bei der Verarbeitung solcher Daten ziemlich schnell sein sollte, wobei eine geringe Latenz berücksichtigt werden sollte. Einige Online-Spiele, an denen Spieler von verschiedenen Orten der Welt beteiligt sind, sammeln viele Daten von Benutzerklicks, Ziehen und anderen Gesten und leiten sie dann in Mikrosekunden zwischen Millionen von Geräten weiter. Das beteiligte Datenbanksystem muss schnell genug sein, um all dies in Echtzeit zu erledigen.

Vielfalt

Daten können in verschiedene Typen kategorisiert werden, darunter Zahlen, Zeichenfolgen, Datum, Objekte, Arrays, Binärdaten, Code, Geodaten und reguläre Ausdrücke, um nur einige zu nennen. Ein optimales Datenbanksystem sollte Funktionen bereitstellen, um die Manipulation dieser Daten zu verbessern, ohne dass zusätzliche Verfahren von der Client-Seite erforderlich sind. Beispielsweise stellt MongoDB die Geolokalisierungsvorgänge für die Verwendung bereit, während Standorte in der Nähe der in der Abfrage angegebenen Koordinaten abgerufen werden. Diese Fähigkeit kann mit herkömmlichen Datenbanken nicht erreicht werden, da sie nur für kleine Datenvolumenstrukturen, weniger Aktualisierungen und einige konsistente Datenstrukturen entwickelt wurden. Außerdem werden im Fall herkömmlicher Datenbanken zusätzliche Operationen benötigt, um ein bestimmtes Ziel zu erreichen.

MongoDB kann auch von mehreren Servern ausgeführt werden, was es im Gegensatz zu herkömmlichen Datenbanken, die nur für die Ausführung auf einem einzigen Server ausgelegt sind, kostengünstig und unendlich macht.

Zu berücksichtigende Faktoren bei der Auswahl von MongoDB für Big Data

Big Data bringt Unternehmensvorteile, wenn sie durch verbesserte Verarbeitungsleistung umfassend verwaltet werden. Bei der Auswahl eines Datenbanksystems sollten einige Faktoren in Bezug auf die Art der Daten berücksichtigt werden, mit denen Sie es zu tun haben, und ob das von Ihnen ausgewählte System diese Fähigkeit bietet. In diesem Blog werden wir in einigen Fällen auf die Vorteile eingehen, die MongoDB für Big Data im Vergleich zu Hadoop bietet.

- Eine reichhaltige Abfragesprache für dynamische Abfragen

- Dateneinbettung

- Hohe Verfügbarkeit

- Indizierung und Skalierbarkeit

- Effiziente Speicher-Engine und Speicherverwaltung

- Datenkonsistenz und -integrität

Rich Query Language für dynamische Abfragen

MongoDB eignet sich am besten für Big Data, wo die resultierenden Daten für die gewünschte Ausgabe weiter bearbeitet werden müssen. Einige der leistungsstarken Ressourcen sind CRUD-Operationen, Aggregations-Framework, Textsuche und die Map-Reduce-Funktion. Innerhalb des Aggregationsframeworks verfügt MongoDB über eine zusätzliche Geolokalisierungsfunktion, die es einem ermöglicht, viele Dinge mit Geodaten zu tun. Wenn Sie beispielsweise einen 2Dsphere-Index erstellen, können Sie Standorte innerhalb eines definierten Radius abrufen, indem Sie einfach die Breiten- und Längenkoordinaten angeben. Bezugnehmend auf das obige Telekommunikationsbeispiel kann das Unternehmen die Map-Reduce-Funktion oder das Aggregations-Framework verwenden, um Anrufe von einem bestimmten Standort zu gruppieren und die durchschnittliche Anrufzeit auf täglicher Basis für seine Benutzer oder mehr andere Operationen zu berechnen. Sehen Sie sich das Beispiel unten an.

Lassen Sie uns eine Standortsammlung mit den Daten erstellen

{ name: "KE",loc: { type: "Point", coordinates: [ -73.97, 40.77 ] }, category: "Parks"}

{ name: "UG",loc: { type: "Point", coordinates: [ -45.97, 40.57 ] }, category: "Parks"}

{ name: "TZ",loc: { type: "Point", coordinates: [ -73.27, 34.43 ] }, category: "Parks"}

{ name: "SA",loc: { type: "Point", coordinates: [ -67.97, 40.77 ] }, category: "Parks"}Mithilfe des Aggregationsframeworks können wir dann Daten für Standorte in der Nähe von [-73.00, 40.00] und innerhalb einer Entfernung von 1 km mit der folgenden Abfrage finden:

db.places.aggregate( [

{

$geoNear: {

near: { type: "Point", coordinates: [ -73.00, 40.00 ] },

spherical: true,

query: { category: "Parks" },

distanceField: "calcDistance",

maxDistance: 10000

}

}

]Map-Reduce-Operation ist auch in Hadoop verfügbar, aber sie ist für einfache Anforderungen geeignet. Der iterative Prozess für Big Data mit Map-Reduce in Hadoop ist ziemlich langsam als in MongoDB. Der Grund dafür ist, dass iterative Aufgaben viele Map- und Reduce-Prozesse vor dem Abschluss erfordern. Dabei werden mehrere Dateien zwischen der Karte generiert und Aufgaben reduziert, was sie für erweiterte Analysen ziemlich unbrauchbar macht. MongoDb hat das Aggregation-Pipeline-Framework eingeführt, um diesen Rückschlag auszugleichen, und es wird in der jüngeren Vergangenheit am häufigsten verwendet.

Dateneinbettung

MongoDB ist dokumentenbasiert mit der Fähigkeit, mehr Felder in ein einzelnes Feld einzufügen, was als Einbettung bezeichnet wird. Das Einbetten hat den Vorteil, dass nur minimale Abfragen für ein einzelnes Dokument ausgegeben werden müssen, da das Dokument selbst viele Daten enthalten kann. Bei relationalen Datenbanken, in denen man viele Tabellen haben kann, müssen Sie für denselben Zweck mehrere Abfragen an die Datenbank senden.

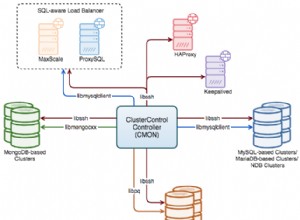

Hohe Verfügbarkeit

Die Replikation von Daten über mehrere Hosts und Server hinweg ist jetzt mit MongoDB möglich, im Gegensatz zu relationalen DBMS, bei denen die Replikation auf einen einzelnen Server beschränkt ist. Dies hat den Vorteil, dass Daten an verschiedenen Orten hochverfügbar sind und Benutzer effizient vom nächstgelegenen Server bedient werden können. Außerdem wird der Prozess der Wiederherstellung oder des Ausfalls leicht erreicht, wenn man die Journaling-Funktion in MongoDB berücksichtigt, die Prüfpunkte erstellt, von denen aus auf den Wiederherstellungsprozess verwiesen werden kann.

Indizierung und Skalierbarkeit

Primäre und sekundäre Indizierung in MongoDB hat viele Vorteile. Durch die Indizierung werden Abfragen zuerst ausgeführt, was für Big Data erforderlich ist, wie wir unter der Geschwindigkeitseigenschaft für Big Data besprochen haben. Die Indizierung kann auch beim Erstellen von Shards verwendet werden. Shards können als Untersammlungen definiert werden, die Daten enthalten, die mithilfe eines Shard-Schlüssels in Gruppen verteilt wurden. Wenn eine Abfrage ausgegeben wird, wird der Shard-Schlüssel verwendet, um zu bestimmen, wo unter den verfügbaren Shards gesucht werden soll. Wenn es keine Shards gäbe, würde der Prozess für Big Data ziemlich lange dauern, da alle Dokumente überprüft werden müssen und der Prozess möglicherweise sogar eine Zeitüberschreitung hat, bevor die Benutzer das bekommen, was sie wollten. Aber mit Sharding wird die abzurufende Datenmenge reduziert und folglich die Latenzzeit beim Warten auf die Rückgabe einer Abfrage reduziert.

Effiziente Speicher-Engine und Speicherverwaltung

Die neueren MongoDB-Versionen legen WiredTiger als Standard-Speicher-Engine fest, die über eine Ausführungsfunktion zur Handhabung mehrerer Workloads verfügt. Diese Speicher-Engine hat viele Vorteile für Big Data, wie in diesem Artikel beschrieben. Die Engine verfügt über Funktionen wie Komprimierung, Checkpointing und fördert mehrere Schreibvorgänge durch Dokumentparallelität. Big Data bedeutet viele Benutzer, und die Parallelitätsfunktion auf Dokumentebene ermöglicht es vielen Benutzern, gleichzeitig in der Datenbank zu bearbeiten, ohne dass es zu Leistungseinbußen kommt. MongoDB wurde mit C++ entwickelt und eignet sich daher gut für die Speicherverwaltung.

Datenkonsistenz und -integrität

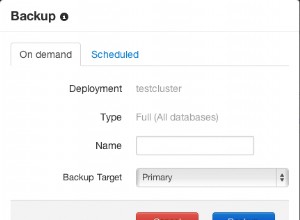

DasJSON-Validierungstool ist eine weitere Funktion, die in MongoDB verfügbar ist, um die Datenintegrität und -konsistenz sicherzustellen. Es wird verwendet, um sicherzustellen, dass keine ungültigen Daten in die Datenbank gelangen. Wenn es beispielsweise ein Feld mit dem Namen „Alter“ gibt, wird immer ein Integer-Wert erwartet. Der JSON-Validator prüft immer, ob für dieses Feld keine Zeichenfolge oder ein anderer Datentyp zur Speicherung an die Datenbank übermittelt wird. Dadurch soll auch sichergestellt werden, dass alle Dokumente Werte für dieses Feld im selben Datentyp haben, wodurch die Datenkonsistenz gegeben ist. MongoDB bietet auch Sicherungs- und Wiederherstellungsfunktionen, sodass man im Fehlerfall zum gewünschten Zustand zurückkehren kann.

Fazit

MongoDB handhabt die Echtzeit-Datenanalyse auf die effizienteste Weise und ist daher für Big Data geeignet. Geospatial Indexing ermöglicht beispielsweise eine Analyse von GPS-Daten in Echtzeit.

Neben der grundlegenden Sicherheitskonfiguration verfügt MongoDB über ein zusätzliches JSON-Datenvalidierungstool, um sicherzustellen, dass nur gültige Daten in die Datenbank gelangen. Da die Datenbank dokumentenbasiert ist und Felder eingebettet wurden, können nur sehr wenige Abfragen an die Datenbank gesendet werden, um viele Daten abzurufen. Damit ist es ideal für den Einsatz, wenn es um Big Data geht.