Dieser Blog bietet Ihnen eine Beschreibung von Hadoop HDFS-High-Availability-Funktion. In diesem Blog werden wir zunächst besprechen, was genau Hochverfügbarkeit ist, wie Hadoop Hochverfügbarkeit erreicht und was die HDFS-Hochverfügbarkeitsfunktion benötigt.

Wir werden auch das Beispiel der Hadoop-Hochverfügbarkeitsfunktion in diesem Big-Data-Hadoop-Tutorial behandeln.

Was ist Hadoop HDFS High Availability?

Hadoop-HDFS ist ein verteiltes Dateisystem. HDFS verteilt Daten auf die Knoten im Hadoop-Cluster, indem es eine Kopie der Datei erstellt. Das Hadoop-Framework speichert diese Replikate von Dateien auf den anderen Computern im Cluster.

Wenn also ein HDFS-Client auf seine Daten zugreifen möchte, kann er problemlos von einer Reihe von Computern im Cluster auf diese Daten zugreifen. Daten sind im nächstgelegenen Knoten im Cluster leicht verfügbar.

Bei einigen ungünstigen Bedingungen wie dem Ausfall eines Knotens kann der Client problemlos auf seine Daten von den anderen Knoten zugreifen. Diese Funktion von Hadoop wird als Hochverfügbarkeit bezeichnet .

Wie wird Hochverfügbarkeit in Hadoop erreicht?

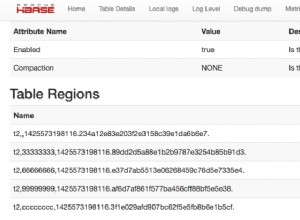

Im HDFS-Cluster gibt es eine Reihe von DataNodes . Nach dem bestimmten Zeitintervall senden alle diese DataNodes Heartbeat-Nachrichten an den NameNode . Wenn der NameNode keine Heartbeat-Meldungen mehr von einem dieser DataNodes empfängt, nimmt er an, dass er tot ist.

Danach überprüft er die in diesen Knoten vorhandenen Daten und gibt dann Befehle an den anderen Datenknoten, um eine Kopie dieser Daten für andere Datenknoten zu erstellen. Daher sind Daten immer verfügbar.

Wenn ein Client einen Datenzugriff in HDFS anfordert, sucht NameNode zunächst nach den Daten in jenen Datenknoten, in denen Daten schnell verfügbar sind. Und stellt dann dem Client Zugriff auf diese Daten zur Verfügung.

Clients müssen nicht in allen Datenknoten nach den Daten suchen. HDFS Namenode selbst macht die Datenverfügbarkeit für die Clients einfach, indem es die Adresse des Datenknotens bereitstellt, von der ein Benutzer direkt lesen kann.

Beispiel für Hadoop-Hochverfügbarkeit

Hadoop HDFS bietet eine hohe Datenverfügbarkeit. Wenn der Client NameNode für Datenzugriff anfordert, sucht NameNode nach allen Knoten, in denen diese Daten verfügbar sind.

Danach bietet es dem Benutzer Zugriff auf diese Daten von dem Knoten, in dem Daten schnell verfügbar waren. Wenn NameNode bei der Suche nach Daten auf allen Knoten im Cluster feststellt, dass ein Knoten tot ist, leitet NameNode die Knoten ohne Wissen des Benutzers um Benutzer auf den anderen Knoten, in dem die gleichen Daten verfügbar sind.

Die Daten werden dem Benutzer ohne Unterbrechung zur Verfügung gestellt. So sind auch bei einem Knotenausfall die Daten für die Benutzer hochverfügbar.

Was waren die Probleme in Legacy-Systemen?

- Daten waren aufgrund eines Computerabsturzes nicht verfügbar.

- Der HDFS-Client muss lange warten, bis er auf seine Daten zugreifen kann. Meistens müssen die Benutzer eine bestimmte Zeit warten, bis die Website verfügbar ist.

- Eingeschränkte Funktionalitäten und Features.

- Aufgrund der Nichtverfügbarkeit von Daten verlängert sich die Fertigstellung vieler Großprojekte in Organisationen über einen langen Zeitraum und Unternehmen müssen daher kritische Situationen durchmachen.

Schlussfolgerung

Daher sind In-Hadoop-Daten hochverfügbar und trotz Hardwareausfall aufgrund mehrerer Kopien von Daten zugänglich. Wenn also ein Knoten oder eine Maschine abstürzt oder ausfällt, können wir auf die Daten über einen anderen Pfad zugreifen. Erfahren Sie mehr über HDFS-Funktionen.

Wenn Sie diesen Blog zu Hadoop High Availability hilfreich finden, teilen Sie Ihre Gedanken bitte im Kommentarbereich mit.