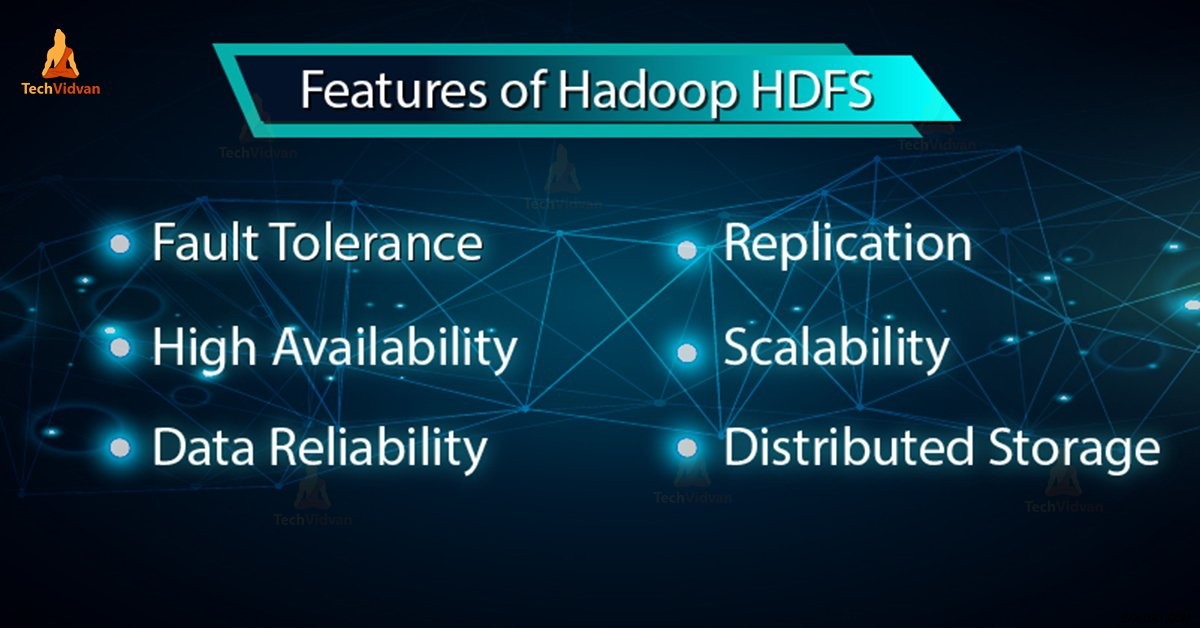

In unserem vorherigen Blog haben wir Hadoop HDFS gelernt Im Detail werden wir jetzt in diesem Blog die Funktionen von HDFS behandeln. Hadoop HDFS verfügt über Funktionen wie Fehlertoleranz, Replikation, Zuverlässigkeit, Hochverfügbarkeit, verteilte Speicherung, Skalierbarkeit usw.

Alle diese Funktionen von HDFS in Hadoop werden in diesem Hadoop HDFS-Tutorial besprochen.

Einführung in Hadoop HDFS

Verteiltes Hadoop-Dateisystem (HDFS) ist das primäre Speichersystem von Hadoop. Es speichert sehr große Dateien, die auf einem Cluster handelsüblicher Hardware ausgeführt werden. HDFS basiert auf GFS (Google FileSystem). Es speichert Daten auch bei einem Hardwareausfall zuverlässig.

HDFS bietet durch parallelen Zugriff auch Zugriff mit hohem Durchsatz auf die Anwendung. Laut einer Prognose werden bis Ende 2017 75 % der weltweit verfügbaren Daten in HDFS gespeichert sein.

6 wichtige Funktionen von HDFS

Lassen Sie uns nach dem Studium der Hadoop HDFS-Einführung nun die wichtigsten Funktionen von HDFS besprechen.

1. Fehlertoleranz

Die Fehlertoleranz in Hadoop HDFS ist die Arbeitsstärke eines Systems unter ungünstigen Bedingungen. Es ist sehr fehlertolerant. Das Hadoop-Framework unterteilt Daten in Blöcke. Danach werden mehrere Kopien von Blöcken auf verschiedenen Computern im Cluster erstellt.

Wenn also eine Maschine im Cluster ausfällt, kann ein Client problemlos auf seine Daten von der anderen Maschine zugreifen, die dieselbe Kopie von Datenblöcken enthält.

2. Hohe Verfügbarkeit

Hadoop HDFS ist ein hochverfügbares Dateisystem. In HDFS werden Daten zwischen den Knoten im Hadoop-Cluster repliziert, indem eine Kopie der Blöcke auf den anderen im HDFS-Cluster vorhandenen Slaves erstellt wird. Wann immer also ein Benutzer auf diese Daten zugreifen möchte, kann er auf seine Daten von den Slaves zugreifen, die seine Blöcke enthalten.

Bei ungünstigen Situationen wie dem Ausfall eines Knotens kann ein Benutzer problemlos auf seine Daten von den anderen Knoten zugreifen. Weil auf den anderen Knoten im HDFS-Cluster doppelte Kopien von Blöcken vorhanden sind.

3. Hohe Zuverlässigkeit

HDFS bietet eine zuverlässige Datenspeicherung. Es kann Daten im Bereich von Hunderten von Petabyte speichern. HDFS speichert Daten zuverlässig auf einem Cluster. Es unterteilt die Daten in Blöcke. Das Hadoop-Framework speichert diese Blöcke auf Knoten, die im HDFS-Cluster vorhanden sind.

HDFS speichert Daten zuverlässig, indem es eine Kopie jedes einzelnen im Cluster vorhandenen Blocks erstellt. Daher bietet Fehlertoleranz-Einrichtung. Wenn der Knoten im Cluster, der Daten enthält, ausfällt, kann ein Benutzer problemlos auf diese Daten von den anderen Knoten zugreifen.

HDFS erstellt standardmäßig 3 Kopien jedes Blocks, der Daten enthält, die in den Knoten vorhanden sind. So stehen die Daten den Benutzern schnell zur Verfügung. Daher steht der Benutzer nicht vor dem Problem des Datenverlusts. Daher ist HDFS sehr zuverlässig.

4. Replikation

Die Datenreplikation ist eine einzigartige Funktion von HDFS. Die Replikation löst das Problem des Datenverlusts bei ungünstigen Bedingungen wie Hardwarefehlern, Knotenabstürzen usw. HDFS hält den Replikationsprozess in regelmäßigen Zeitabständen aufrecht.

HDFS erstellt auch weiterhin Repliken von Benutzerdaten auf verschiedenen Computern im Cluster. Wenn also ein Knoten ausfällt, kann der Benutzer auf die Daten anderer Maschinen zugreifen. Somit besteht keine Möglichkeit, Benutzerdaten zu verlieren.

5. Skalierbarkeit

Hadoop HDFS speichert Daten auf mehreren Knoten im Cluster. Wenn also die Anforderungen steigen, können Sie den Cluster skalieren. In HDFS sind zwei Skalierbarkeitsmechanismen verfügbar:Vertikal und Horizontale Skalierbarkeit.

6. Verteilter Speicher

Alle Funktionen in HDFS werden über verteilte Speicherung und Replikation erreicht. HDFS speichert Daten verteilt über die Knoten. In Hadoop werden Daten in Blöcke unterteilt und auf den im HDFS-Cluster vorhandenen Knoten gespeichert.

Danach erstellt HDFS das Replikat jedes einzelnen Blocks und speichert es auf anderen Knoten. Wenn eine einzelne Maschine im Cluster abstürzt, können wir einfach von den anderen Knoten, die ihre Replik enthalten, auf unsere Daten zugreifen.

Schlussfolgerung

Zusammenfassend können wir sagen, dass HDFS sehr fehlertolerant ist. Es speichert zuverlässig große Datenmengen trotz Hardwarefehler. Es bietet auch eine hohe Skalierbarkeit und hohe Verfügbarkeit. Daher ermöglicht HDFS die Hadoop-Funktionalität. Wenn Sie eine andere Funktion von HDFS finden, teilen Sie uns dies bitte im Kommentarbereich unten mit.