Apache Hadoop ist ein Software-Framework, das Big Data über den Cluster von Commodity-Hardware verarbeitet und speichert. Hadoop basiert auf dem MapReduce-Modell zur verteilten Verarbeitung großer Datenmengen.

In diesem MapReduce-Tutorial wurden mehrere Funktionen von MapReduce vorgestellt. Nachdem Sie dies gelesen haben, werden Sie klar verstehen, warum MapReduce am besten für die Verarbeitung großer Datenmengen geeignet ist.

Zuerst sehen wir eine kleine Einführung in das MapReduce-Framework. Dann werden wir verschiedene Funktionen von MapReduce erkunden.

Beginnen wir mit der Einführung in das MapReduce-Framework.

Einführung in MapReduce

MapReduce ist ein Software-Framework zum Schreiben von Anwendungen, die riesige Datenmengen über die Cluster kostengünstiger Knoten hinweg verarbeiten können. Hadoop MapReduce ist der Verarbeitungsteil von Apache Hadoop.

Es wird auch als das Herz von Hadoop bezeichnet. Es ist die am meisten bevorzugte Datenverarbeitungsanwendung. Mehrere Akteure im E-Commerce-Sektor wie Amazon, Yahoo und Zuventus usw. verwenden das MapReduce-Framework für die Verarbeitung großer Datenmengen.

Sehen wir uns nun die verschiedenen Funktionen von Hadoop MapReduce an.

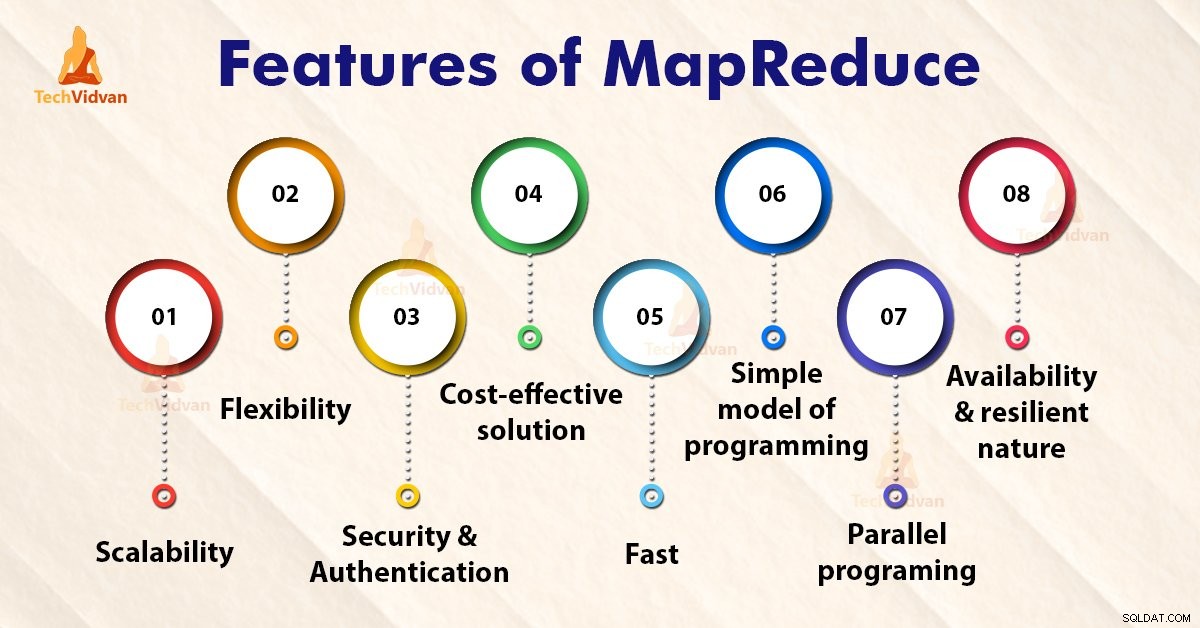

Funktionen von MapReduce

1. Skalierbarkeit

Apache Hadoop ist ein hochskalierbares Framework. Dies liegt an seiner Fähigkeit, riesige Datenmengen auf vielen Servern zu speichern und zu verteilen. Alle diese Server waren kostengünstig und können parallel betrieben werden. Wir können die Speicher- und Rechenleistung einfach skalieren, indem wir dem Cluster Server hinzufügen.

Die Hadoop MapReduce-Programmierung ermöglicht es Unternehmen, Anwendungen von großen Knotensätzen aus auszuführen, was die Verwendung von Tausenden von Terabyte an Daten beinhalten könnte.

Die Hadoop MapReduce-Programmierung ermöglicht es Unternehmen, Anwendungen von einer großen Anzahl von Knoten aus auszuführen. Dies kann Tausende von Terabyte an Daten verwenden.

2. Flexibilität

Die MapReduce-Programmierung ermöglicht Unternehmen den Zugang zu neuen Datenquellen. Es ermöglicht Unternehmen, mit verschiedenen Arten von Daten zu arbeiten. Es ermöglicht Unternehmen, sowohl auf strukturierte als auch auf unstrukturierte Daten zuzugreifen und einen erheblichen Mehrwert zu erzielen, indem sie Erkenntnisse aus den verschiedenen Datenquellen gewinnen.

Darüber hinaus bietet das MapReduce-Framework auch Unterstützung für mehrere Sprachen und Daten aus Quellen, die von E-Mail, sozialen Medien bis hin zu Clickstream reichen.

MapReduce verarbeitet Daten in einfachen Schlüssel-Wert-Paaren und unterstützt daher Datentypen wie Metadaten, Bilder und große Dateien. Daher ist MapReduce flexibel im Umgang mit Daten und nicht mit herkömmlichen DBMS.

3. Sicherheit und Authentifizierung

Das MapReduce-Programmiermodell verwendet eine HBase- und HDFS-Sicherheitsplattform, die nur den authentifizierten Benutzern den Zugriff ermöglicht, um mit den Daten zu arbeiten. Somit schützt es vor unbefugtem Zugriff auf Systemdaten und erhöht die Systemsicherheit.

4. Kostengünstige Lösung

Die skalierbare Architektur von Hadoop mit dem MapReduce-Programmierframework ermöglicht die Speicherung und Verarbeitung großer Datenmengen auf sehr erschwingliche Weise.

5. Schnell

Hadoop verwendet eine verteilte Speichermethode namens Hadoop Distributed File System, die im Grunde ein Mapping-System zum Auffinden von Daten in einem Cluster implementiert.

Die Tools, die für die Datenverarbeitung verwendet werden, wie z. B. die MapReduce-Programmierung, befinden sich in der Regel auf denselben Servern, die eine schnellere Verarbeitung von Daten ermöglichen.

Selbst wenn wir es also mit großen Mengen unstrukturierter Daten zu tun haben, benötigt Hadoop MapReduce nur wenige Minuten, um Terabytes an Daten zu verarbeiten. Es kann Petabytes an Daten in nur einer Stunde verarbeiten.

6. Einfaches Programmiermodell

Unter den verschiedenen Features von Hadoop MapReduce ist eines der wichtigsten Features, dass es auf einem einfachen Programmiermodell basiert. Grundsätzlich erlaubt dies Programmierern, MapReduce-Programme zu entwickeln, die Aufgaben einfach und effizient erledigen können.

Die MapReduce-Programme können in Java geschrieben werden, was nicht sehr schwer zu verstehen ist und auch weit verbreitet ist. So kann jeder MapReduce-Programme leicht lernen und schreiben und seine Datenverarbeitungsanforderungen erfüllen.

7. Parallele Programmierung

Einer der Hauptaspekte der MapReduce-Programmierung ist die parallele Verarbeitung. Es teilt die Aufgaben so auf, dass sie parallel ausgeführt werden können.

Die parallele Verarbeitung ermöglicht es mehreren Prozessoren, diese aufgeteilten Aufgaben auszuführen. So wird das gesamte Programm in kürzerer Zeit ausgeführt.

8. Verfügbarkeit und Belastbarkeit

Immer wenn die Daten an einen einzelnen Knoten gesendet werden, wird derselbe Datensatz an einige andere Knoten in einem Cluster weitergeleitet. Wenn also ein bestimmter Knoten ausfällt, sind immer noch andere Kopien auf anderen Knoten vorhanden, auf die bei Bedarf immer noch zugegriffen werden kann. Dies gewährleistet eine hohe Datenverfügbarkeit.

Eine der Hauptfunktionen von Apache Hadoop ist seine Fehlertoleranz. Das Hadoop MapReduce-Framework hat die Fähigkeit, auftretende Fehler schnell zu erkennen.

Es wendet dann eine schnelle und automatische Wiederherstellungslösung an. Diese Funktion macht es zu einem Wendepunkt in der Welt der Big-Data-Verarbeitung.

Zusammenfassung

Ich hoffe, dass Sie nach dem Lesen dieses Artikels die verschiedenen Funktionen von Hadoop MapReduce klar verstanden haben. Der Artikel führte verschiedene Funktionen von MapReduce ein. Das MapReduce-Framework ist ein skalierbares, flexibles, kostengünstiges und schnell verarbeitendes System.

Es bietet Sicherheit, Fehlertoleranz und Authentifizierung. MapReduce ist ein einfaches Programmiermodell und bietet parallele Programmierung.